Pensando sobre o ecossistema de Rocky Balboa (Sylvester Stallone), seja você um amante ou não dos filmes, é inegável que a série traz um drama especial com fases que sustentam e evoluem uma necessidade intrínseca muitas vezes identificada tardiamente: a resiliência.

Na PGConf.Brasil 2022, Emanuel Araujo consultor da Timbira, explicou que a resiliência nada mais é do que nossa capacidade de adaptação em meio a situações complicadas ou adversas. Durante sua palestra, ele definiu a adaptação como um equilíbrio físico e psicológico diante das adversidades cotidianas. E também que, embora não tenhamos controle sobre todos os aspectos de nossas vidas e eventos aleatórios que nos acometem, temos o controle sobre o modo como reagimos a essas situações.

“Você tem poder sobre sua mente – não sobre eventos externos. Perceba isso e você encontrará sua força” (Marco Aurélio).

Emanuel destacou que Marco Aurélio já nos alertava sobre a importância de lidarmos com nossos pensamentos e não nos deixarmos abater por eventos externos. A trajetória de Rocky exemplifica como um conjunto de experiências pode fortalecer a resiliência e o amadurecimento pessoal ao longo dos filmes.

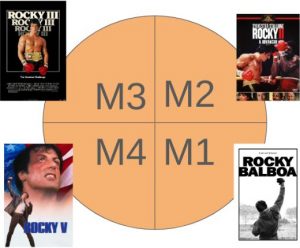

Traçando um paralelo entre os quatro primeiros filmes da série, e os quadrantes de maturidade, Emanuel explicou como funciona esse modelo teórico usado para descrever os estágios de desenvolvimento de habilidades, competências ou maturidade em diversos contextos, sejam pessoais, profissionais ou organizacionais.

Quadrante M1

No início, Rocky é um iniciante desajeitado e canhoto, um estrangeiro no mundo do boxe, mas de bom coração (M1). Ele não tem capacidade técnica e precisa apenas executar sem pensar muito. O bom coração de Rocky reflete suas soft skills, que se desenvolvem ao longo da série, acompanhando sua evolução.

Quadrante M2

Seguindo o roteiro, depois de empatar na sua luta final, podemos dizer que Rocky passou de fase. Chegando então ao quadrante M2, já possuindo experiência mínima, é bem visto pelo público, ganhou confiança e agora precisa não apenas executar, mas adquirir a competência de pensar antes de agir, ou seja, planejar sua execução. Com a nova grande chance que tem, seu treino se torna mais customizado e sua responsabilidade aumenta a cada novo dia. O planejamento da nova estratégia de luta foi decisivo e ao final o tornou campeão mundial de boxe.

Quadrante M3

No terceiro quadrante, surgem as armadilhas do nível 3 de maturidade: o excesso de confiança, conforto e a incapacidade de pensar em riscos. Um bom momento para reparar que em momentos da vida podemos estar no topo e em seguida no chão do ringue. Rocky se vê em um buraco, pois além de perder vergonhosamente o título mundial, perde seu treinador Mickey (Burgess Meredith), que morreu de ataque cardíaco antes da luta com Clubber Lang (Mr. T) iniciar. Existem grandes batalhas na vida e perder entes queridos é uma delas. A culpa de não poder ter feito mais, a dependência de não poder contar com determinadas pessoas, passa dia após dia em nossas mentes, nos testando ou nos preparando. No terceiro nível de maturidade ocorrem situações onde precisamos saber muito bem quem somos, para não assumirmos o que não podemos, achando que somos invencíveis, até nos depararmos com uma palavrinha chamada medo.

O medo é diferente do pânico

Medo é estado de alerta, é um sentimento que nos dá a capacidade de reagir, de planejar, de ter o cuidado com o que estamos fazendo e com as situações em que nos encontramos. Foi justamente o reconhecimento disso e o apoio de sua esposa Adrian (Talia Shire) que fizeram Rocky mudar o seu posicionamento e voltar a treinar. Agora com seu ex-adversário, e então amigo, Apollo (Carl Weathers), Rocky possui o suporte necessário para desenvolver um planejamento, uma estratégia de luta com disciplina e alegria de estar fazendo o que gosta com as pessoas certas ao seu lado, um verdadeiro time, para no final voltar a ser o campeão mundial de boxe.

Quadrante M4

No quadrante M4, Rocky enfrenta uma nova adversidade: a morte de Apollo Creed. Depois de ter passado por várias situações da vida, a morte de Mickie, o topo, a família, o fracasso, o medo, com o nível de resiliência alto, Rocky passa por uma nova fase. Em meio a um contexto de rivalidade entre EUA e URSS, o que deveria ser uma luta de exibição acaba com a morte de seu amigo e treinador, Apollo. A grande diferença do quadrante M4 é que nosso nível de resiliência está mais robusto, preenchido de experiências e sentimentos já conhecidos, e com isso temos a capacidade de adaptação aos novos eventos, reconhecê-los, resolvê-los ou tomar decisões com muito mais controle.

A cena em que Rocky está dirigindo seu carro após o enterro de Apollo, mostra a capacidade de refletirmos sobre nosso passado, erros, acertos e sentimentos. O filme que passa pela cabeça de Rocky mostra exatamente isso. A sua decisão de lutar na URSS, no dia de Natal, em um local completamente adverso, não apenas pelo frio intenso, mas também pela hostilidade que encontrará por ser um lutador americano, demonstra claramente sua evolução dentro da trajetória de maturidade. Rocky compreende a dificuldade que enfrentará e olha para todo o processo através de uma lente de humildade, buscando abrigo no isolamento e focando todos seus esforços em treinar sem ninguém para julgar ou atrapalhar a concentração de seu treino. Consciente do momento que está vivendo ele traz para perto de si aquelas pessoas em quem ele confia plenamente e que lhe dão o suporte necessário para atingir seus objetivos. Todas essas etapas sendo muito bem pensadas, planejadas e com a equipe certa para fazer o trabalho certo, o levaram aos melhores resultados possíveis.

Rocky V

“Rocky 5” fecha com chave de ouro o pilar de liderança espontânea, quando Rocky passa a treinar um jovem potencial, do zero ao título. Isso não seria algo comum aos líderes que transformam empresas? Ser o agente de mudança de sua equipe ou de sua família? Essa continuação podemos deixar para um próximo post.

Processo de Maturidade

Esse ciclo de maturidade representa vários contextos e está representados em cada etapa de nossa vida profissional e pessoal, o exemplo do Rocky Balboa é apenas uma forma de ilustrarmos essa trajetória. Posso ser M1 na cozinha e M4 em programação java, por exemplo. Cada competência, etapa ou contexto evolui através de um processo de maturação que está intrinsecamente ligado às experiências acumuladas ao longo do tempo. Esse processo não apenas fortalece nossa resiliência, como também amplia nossa capacidade de lidar com desafios e adversidades.

Keep calm, reflita e vamos buscar ser melhores do que ontem.

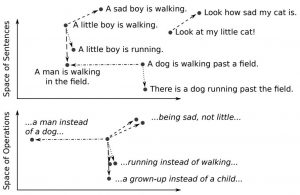

Figura 1: Uma ilustração de um espaço vetorial multidimensional contínuo representando frases individuais. Fonte: [2]

Figura 1: Uma ilustração de um espaço vetorial multidimensional contínuo representando frases individuais. Fonte: [2]