A escolha do banco de dados certo é fundamental para o sucesso e a competitividade de uma empresa. Gestores e líderes frequentemente se veem diante da pergunta: “Qual é o melhor banco de dados para minha empresa?”. Nesse contexto, o PostgreSQL se destaca como uma opção confiável, econômica e promissora. Não apenas por oferecer robustez, desempenho e uma política de licenciamento gratuito, mas também por seu crescimento cada dia mais acelerado, se tornando uma escolha inteligente para empresas de diferentes tamanhos e setores.

Vamos explorar as razões pelas quais o Postgres se destaca como uma boa opção a ser avaliada, fornecendo uma visão mais aprofundada sobre seus recursos, extensibilidade e desempenho.

Extensibilidade

O PostgreSQL é conhecido por sua extensibilidade, oferecendo suporte a uma ampla variedade de tipos de dados e recursos avançados. Sua arquitetura altamente extensível permite a criação de tipos de dados personalizados, funções definidas pelo usuário, mecanismos de acesso (índices) e armazenamento (tabelas) customizados, decodificadores de WAL (Write-ahead Logging) para serem utilizados, por exemplo, em CDC (Change Data Capture), integração com fontes de dados externa por meio de FDW (Foreign Data Wrappers), mudanças de comportamento através de diversos pontos de introspecção (hooks), entre outros diversos recursos que podem ser criados em forma de extensões e que atendem às necessidades específicas de cada ambiente. Essa extensibilidade do Postgres possibilita às empresas personalizarem o sistema de acordo com suas necessidades específicas, facilitando a adaptação do negócio às mudanças demandadas pelo mercado.

Escalabilidade

À medida que as empresas crescem e seus volumes de dados aumentam, é essencial que o ambiente do banco de dados também esteja preparado para crescer. Uma das principais vantagens do PostgreSQL é que ele possibilita a escalabilidade horizontal através do uso de réplicas, aprimorando a distribuição do processamento de grandes volumes de dados. Sendo um software de código aberto, o Postgres não possui custos de licenciamento nem restrições de uso em múltiplos processadores e, como não há um custo com licenciamento, o investimento pode ser direcionado para outros recursos, como hardware por exemplo, ou ainda gerar uma economia direta de custos.

Comunidade Ativa

Com uma comunidade ativa e engajada de desenvolvedores, contribuidores e usuários em todo o mundo, é possível promover a inovação contínua e o aprimoramento do PostgreSQL, fornecendo atualizações regulares, correções de bugs e novos recursos. Além disso, a comunidade oferece suporte técnico gratuito por meio de fóruns online, listas de discussão e grupos de usuários locais, garantindo que as empresas sempre tenham acesso ao conhecimento e à experiência, necessários para resolver problemas e otimizar o desempenho nos seus ambientes Postgres.

“PostgreSQL Para Tudo”

O PostgreSQL alcançou um nível de maturidade que supera a popularidade de muitos bancos de dados pagos. Além de ser um banco de dados relacional, o Postgres oferece uma ampla variedade de recursos, tornando-se um hub central para diversas necessidades. Sendo o banco de dados mais extensível no momento, ele possibilita diversos processos empresariais devido a sua capacidade de adaptação a uma variedade extensa de cenários. Isso tem sido tão significativo que cada vez mais projetos são desenvolvidos através do PostgreSQL, demonstrando sua influência e versatilidade.

Por que escolher o Postgres para tudo? Porque, na maioria dos casos, ele oferece tudo o que é necessário, evitando a complexidade desnecessária de adotar ou adquirir múltiplas soluções.

Com um enorme ecossistema e uma variedade de extensões disponíveis, o PostgreSQL já possui soluções para muitos dos problemas comuns enfrentados no dia a dia das empresas. A comunidade interage de maneira construtiva formando extensões oficiais e não oficiais para a resolução de problemas que, frequentemente, são resolvidos em outros bancos com a necessidade de utilizar outras aplicações, por exemplo.

Uma boa observação a ser feita é que não estamos dizendo para descartar outras tecnologias, mas sim destacando a capacidade do PostgreSQL de ser a solução central em muitos casos.

Política de Licenciamento Gratuito

A escolha entre contratar um banco de dados pago para ter suporte ou optar pelo Postgres e contar com a possibilidade de contratar serviços especializados de consultoria, é uma dúvida bastante comum que depende muito das necessidades e recursos específicos da empresa.

Os bancos de dados pagos geralmente incluem um custo inicial mais alto devido às taxas de licenciamento e suporte técnico direto do fornecedor. À primeira vista, isso pode parecer vantajoso e sugerir que exista a segurança de um suporte rápido e confiável em caso de necessidade. No entanto, esse tipo de suporte pode ser terceirizado e a qualidade do serviço pode mudar significativamente ou contar com tempos de resposta mais lentos. Além disso, para esse tipo de banco de dados podem haver custos adicionais para atualizações, módulos extras, suporte premium, e manutenção.

O PostgreSQL é gratuito para uso, o que pode resultar em economias significativas, especialmente para empresas com orçamentos mais limitados. Para empresas que optam pelo Postgres, há a possibilidade de contratar serviços especializados de consultoria, o que pode ser mais econômico a longo prazo. Claro que, para atingir esse objetivo, deve-se levar em conta questões além dos custos da consultoria, como a preocupação da empresa contratada em manter a sustentabilidade do ambiente Postgres do contratante e o quanto a empresa trabalha em prol da autonomia dos seus clientes, levando à uma independência futura.

Conte conosco!

Oferecemos consultoria especializada em PostgreSQL para ajudar empresas a encontrarem um crescimento tecnológico sustentável através de uma combinação de expertise técnica e visão de negócios, que vai do panorama estratégico até a implementação operacional.

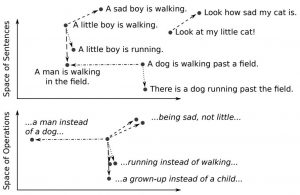

Figura 1: Uma ilustração de um espaço vetorial multidimensional contínuo representando frases individuais. Fonte: [2]

Figura 1: Uma ilustração de um espaço vetorial multidimensional contínuo representando frases individuais. Fonte: [2]